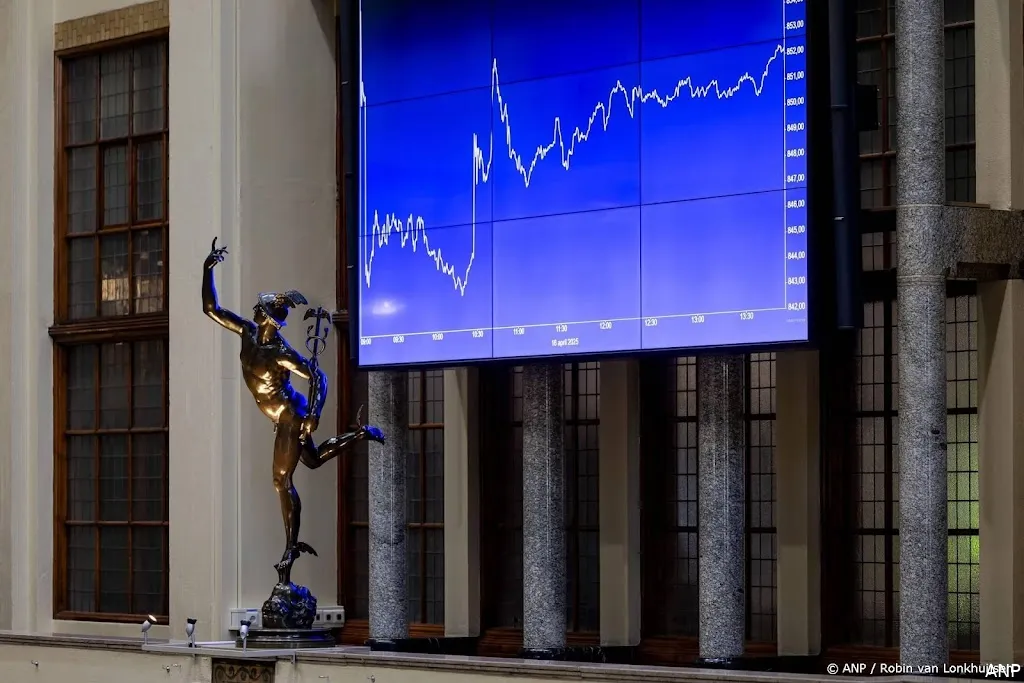

AMSTERDAM (ANP) - De Europese beurzen zijn donderdag met verliezen de handel uitgegaan, in navolging van minnen op Wall Street. Nu de shutdown van de Amerikaanse overheid voorbij is, lijken bij beleggers de zorgen over de Amerikaanse economie en rente weer toe te nemen.

De AEX-index in Amsterdam sloot 0,7 procent lager op 961,51 punten en de belangrijkste beursgraadmeters in Parijs, Londen en Frankfurt daalden tot 1,4 procent. Het einde van de shutdown zorgde aan het begin van de handelsdag nog voor enige opluchting. Maar het sentiment sloeg in de loop van de sessie om.

Door de shutdown werden afgelopen weken veel cijferpublicaties uitgesteld. De verwachting is dat deze data binnenkort naar buiten komen. Beleggers zijn er nog niet gerust op dat de gegevens de weg vrijmaken voor een verdere renteverlaging door de Federal Reserve.

De MidKap-index, met daarin de middelgrote fondsen in Amsterdam, ging wel 0,9 procent vooruit naar 879,40 punten. Dat was onder meer te danken aan flinke koerswinst van SBM Offshore.

De maritieme oliedienstverlener zag de omzet afgelopen kwartaal flink stijgen en werd opnieuw iets positiever over het resultaat dit jaar. Topman Øivind Tangen sprak van sterke prestaties en een toenemende activiteit in de belangrijkste markten van het bedrijf. Het aandeel won ruim 8 procent.

Het Damrak verwerkte ook cijfers van Aegon, dat dik 1 procent won bij de hoofdfondsen. Volgens topman Lard Friese boekt de verzekeraar goede vooruitgang met de transformatie van de activiteiten. Transamerica, de grootste divisie van Aegon, bouwde het distributienetwerk verder uit. Ook de vermogensbeheertak en de internationale activiteiten bleven groeien.

Buiten Nederland was Siemens een grote verliezer. De beurswaarde van het Duitse industrieconcern zakte meer dan 9 procent in Frankfurt na tegenvallende cijfers. Siemens meldde weliswaar een nieuwe recordwinst, maar kwam daarbij met voorzichtige prognoses voor het nieuwe jaar.

/s3/static.nrc.nl/wp-content/uploads/2025/11/11154113/131125WET_2022933762_Hond_2.jpg)